Marvell发力定制AI芯片,冲刺万亿级数据中心市场

2025年6月17日,芯片公司Marvell举行了一场聚焦AI基础设施的线上投资者峰会。尽管Marvell在公众视野中一向低调,但这场峰会却释放出极强的信号——它正全力押注“定制化AI芯片”,试图在未来的AI浪潮中,抢占数据中心芯片的核心位置。

随着AI大模型的发展不断深入,传统通用芯片已逐渐无法满足云端训练与推理的高能效比需求。相较之下,专为特定客户与任务定制的芯片具备更高的灵活性与性能优化空间,成为大型科技公司的首选。Marvell正是这一趋势下的关键玩家,为亚马逊AWS、微软Azure、Meta以及xAI等提供底层算力支持。值得一提的是,AWS首席执行官在峰会上公开表示,与Marvell的合作让其AI云平台具备了更强的性能和可扩展性,可见其战略地位。

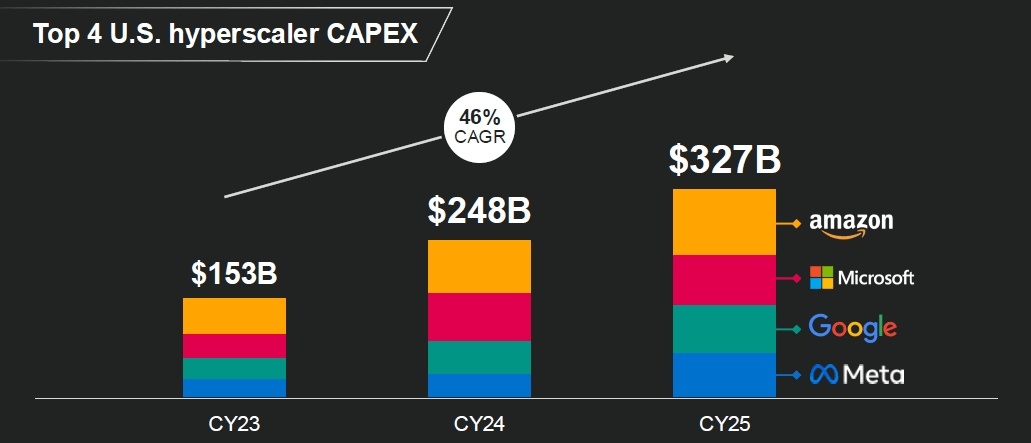

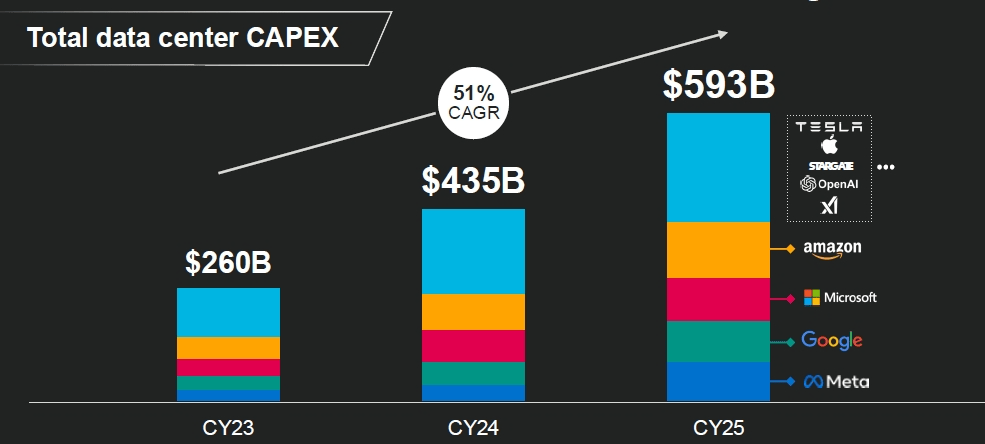

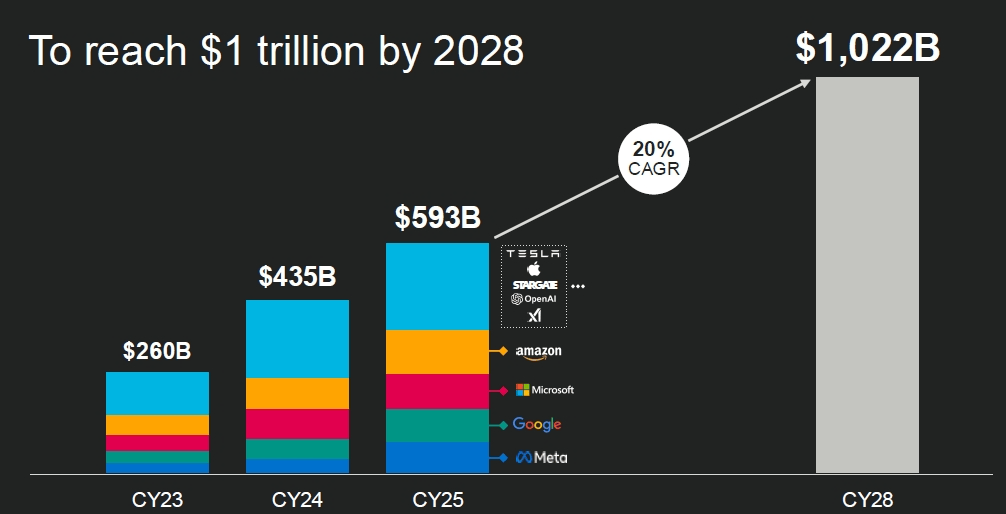

从市场规模来看,AI基础设施的投资正在呈指数级扩张。根据Marvell引用的数据,2023年全球数据中心资本支出为2600亿美元,预计到2028年将突破1万亿美元,年复合增长率达20%。其中,专为AI服务的“加速计算”芯片市场,将在2028年达到3490亿美元,包括主控芯片和周边协同芯片在内。其中,定制主芯片的市场规模为1460亿美元,年均增长47%;而定制配套芯片(如内存管理器、网络接口、协处理器等)的增长更为惊人,年均复合增长率高达90%,市场规模预计将达到4080亿美元。

目前Marvell在这一市场仍属“黑马”角色,其2023年在该领域的市占率不足5%,但其目标是到2028年实现20%的市场份额,占据“加速计算定制芯片”领域的核心地位。按照其内部预测,未来五年内,每一个定制主芯片项目都将带来数十亿美金的收入,而每一个配套芯片项目也能贡献数亿美元,生命周期达2至4年。目前,Marvell已赢得18个相关芯片项目,其中包括与Top 4美国云服务商的12个合作,客户数量超过10家,潜在项目机会超过50个,合计收入有望超过750亿美元。

在技术层面,Marvell展现出强大的自主研发能力。其团队已实现全球首批2纳米工艺的芯片流片,并在超高密度内存、高速信号传输、硅光技术和先进封装方面持续突破。峰会中公布的最新自研SRAM技术,在带宽密度上比现有方案高出17倍,面积减半,待机功耗降低66%;而新一代SerDes(高速信号接口)在50dB信号衰减下依然保持极低误码率与清晰信号,性能全球领先。此外,Marvell在先进封装领域也动作频频,提出了从2.5D、3.5D再到4.5D的多维封装方案,结合硅光模块和芯粒互连技术,实现更高性能和更低功耗的系统集成。

Marvell目前的数据中心业务已初见成效。2025财年公司该业务的收入达到42亿美元,其中超过25%来自定制芯片,预计未来这一占比将超过50%。伴随更多项目的落地,公司整体成长路径也愈加明确。值得注意的是,相较于英伟达的GPU和通用芯片解决方案,Marvell所聚焦的定制芯片市场更为垂直和高门槛,这也赋予其极强的客户粘性与技术壁垒。

AI芯片市场正快速向“高度定制化”演进,而Marvell无疑是这场技术演化中的关键推手之一。它不做C位主角,却掌握着AI算力底层的“控制权”。在未来几年AI基础设施大规模部署与升级的浪潮中,Marvell很可能凭借其强大的设计能力、先进工艺与客户合作基础,成为真正的“幕后赢家”。