深圳AI龙头,宣布重磅AI芯片战略聚焦

芯东西(公众号:aichip001)

作者 | ZeR0

编辑 | 漠影

10年、五代NPU、全自主可控,国内最早探索AI推理芯片的企业之一、深圳AI龙头企业云天励飞,刚刚披露最新的AI芯片战略规划。

芯东西7月28日报道,在世界人工智能大会期间,云天励飞宣布全面聚焦AI芯片,披露最新AI推理芯片全产品矩阵及未来三年商用路线图,计划到2028年将单芯片算力最高扩展至数千TOPS。

通过三代“算力积木”架构,云天励飞布局三大商用平台(深界、深擎、深穹),提供从端到云的完整AI推理解决方案,能高效支撑不同尺寸的AI大模型部署需求。

云天励飞董事长兼CEO陈宁、云天励飞CTO李爱军与芯东西进行深入交流,不仅完整回顾芯片研发历程,还详细分享了其AI推理芯片的技术实力和研发布局。

其技术优势可概括为4个关键词:自研指令集架构,“纯血”国产工艺,高性价比推理,向后兼容。

一、五代芯片、三大平台,满足大模型部署需求

NPU这条路,云天励飞已经走了10年。

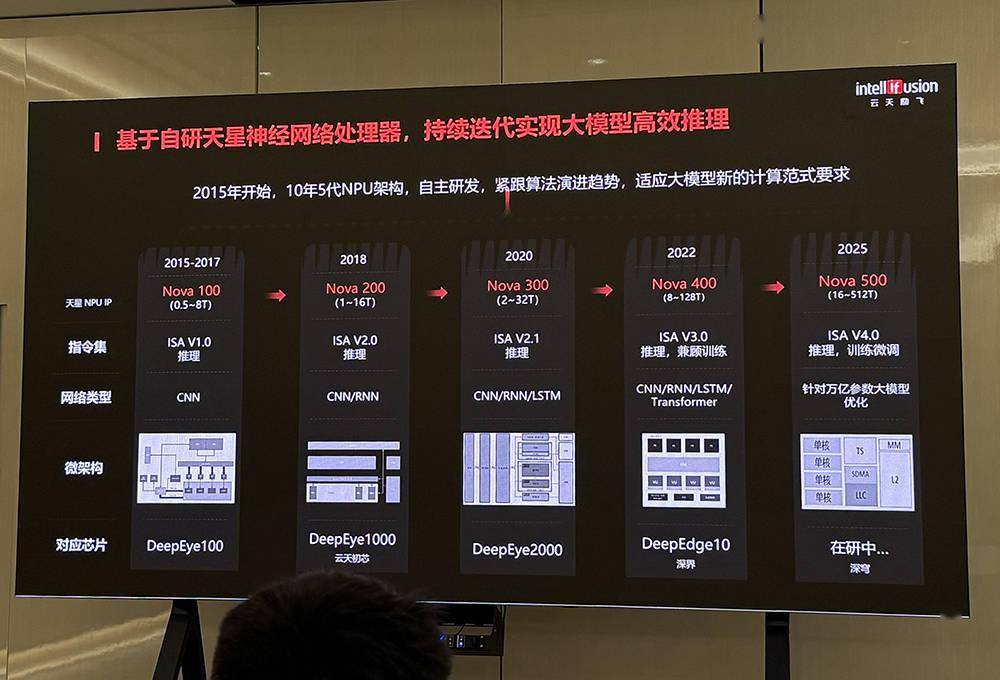

从2015年开始自研芯片至今,云天励飞结合主流神经网络算法从CNN向RNN、LSTM、Transformer演进的趋势,打造相关指令集、专用算子、存算一体架构、低比特混合量化等芯片硬件技术,推出深界、深穹、深擎三大AI推理芯片平台。

其产品线覆盖端、边、云推理。根据云天励飞披露的路线图,正在研发的深穹芯片平台针对万亿参数大模型进行优化,峰值算力将达到512TOPS。

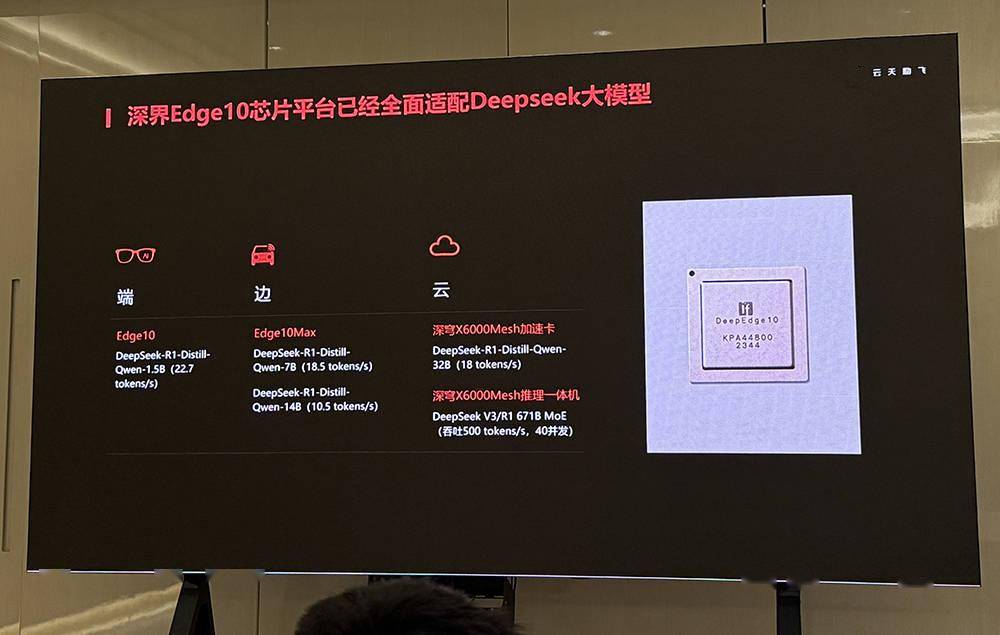

云天励飞的深界Edge10芯片平台是一款面向边缘AI计算场景的基于第一代“算力积木”架构的主控级SoC。它采用自研第四代NPU Nova 400,高效支持Transformer。

目前,深界Edge10已全面适配DeepSeek大模型。相应的DeepSeek推理一体机已落地,跑满血版DeepSeek V3/R1 671B MoE模型,吞吐量达到500 tokens/s。

其中,深界Edge10C是最小款,采用15 x 15小尺寸封装,支持2、4、6颗Edge10C芯片的C2C算力级联,可满足AIoT场景中视频高密、7B/14B/32B大语言模型、多模态大模型的推理需求。

半高半长卡可以放6颗Edge10C的C2C算力积木布局,整体功率不到70W,能效优势突出。

算力更大的Edge10/10max,则能支撑边缘端设备的多模态大模型落地。

据介绍,Edge10芯片平台的16TOPS + 64TOPS组合,是当前最贴近CV大模型、视频文搜大模型、视觉语义搜大模型应用落地的高性价比边缘端推理芯片。

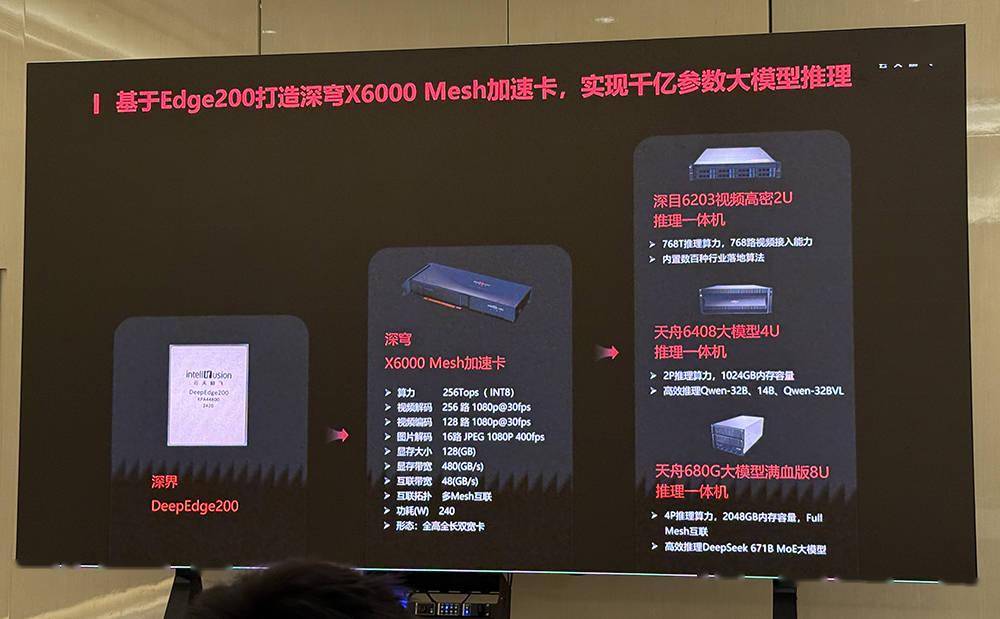

深穹X6000 Mesh加速卡是一款全高全长双宽卡,基于深界Edge200打造,支持千亿参数大模型推理,最高算力达256TOPS。

采用该加速卡的Qwen、DeepSeek推理一体机已经推出并落地。

二、纯血国产工艺+“算力积木”架构,迈向万亿参数大模型推理

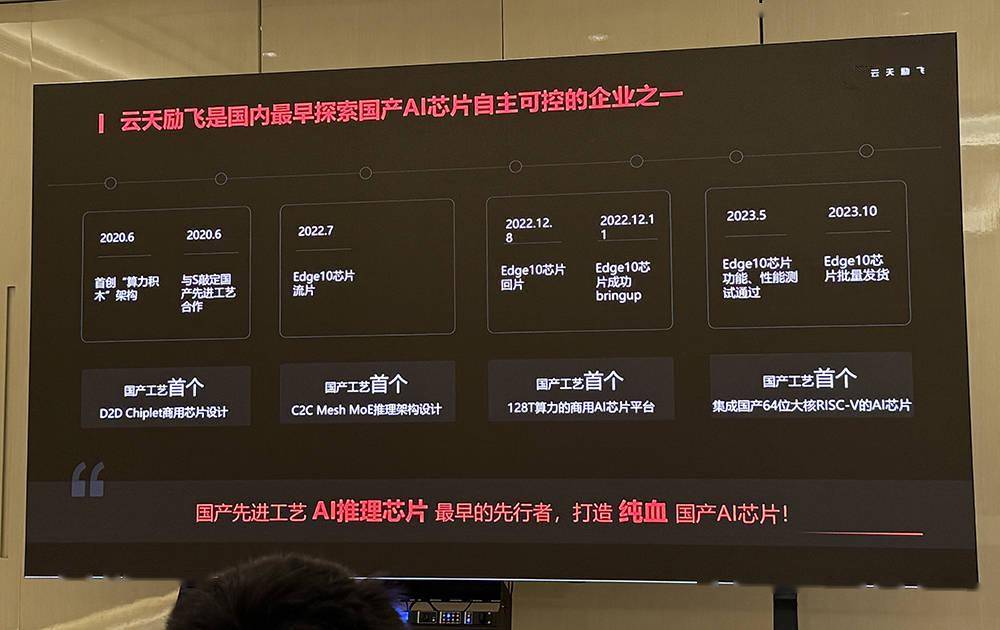

云天励飞是国内最早探索国产先进工艺AI推理芯片的企业之一,坐拥4个“国产工艺首个”:

- 国产工艺首个D2D Chiplet商用芯片设计

- 国产工艺首个C2C Mesh MoE推理架构设计

- 国产工艺首个128T算力的商用AI芯片平台

- 国产工艺首个集成国产64位大核RISC-V的AI芯片

其深界DeepEdge10芯片平台已通过广五所自主可控国产化C级认证,板级方案通过100%国产化率验证。

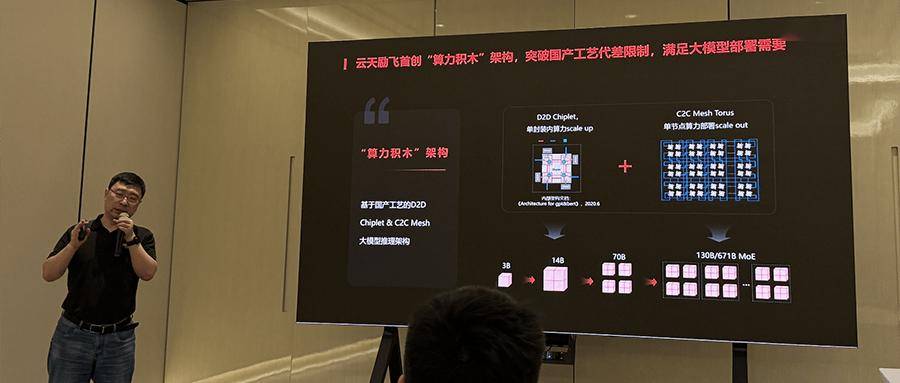

云天励飞自研芯片的独门秘籍,是其自创的“算力积木”架构。

这是一款基于国产工艺的D2D Chiplet & C2C Mesh大模型推理架构,通过灵活模块化的设计、高效的算力调度和低延迟的数据传输,突破国产工艺代差限制,将算力扩展至能满足从3B到671B MoE大模型的高效推理需求。

D2D Chiplet实现了单芯片算力增强,C2C Mesh互连则实现片间算力扩展,可满足千亿级大模型部署需求。

李爱军告诉芯东西,算力积木的方式将4个“积木”互连,跑7B模型的加速时间占比超过90%,损失只有8%。相比国际大厂的封闭专用互连技术,NB-Link基于相对更通用的PCIe接口,能与大多数主流国产CPU芯片实现高效互连互通,使Agent应用扩地更加高效、

第二代“算力积木”架构计划通过5大创新(新型计算、近存计算、NB-Mesh新型互连、新型封装、NB-Link通用扩展性),打造新型大模型推理计算平台,满足嵌入式物联网、边缘端、云推理对边缘大模型MoE大模型的极致推理效率、能效、性价比的刚性需求。

5大创新具体包括:

(1)新型计算单元:采用第五代NPU Nova500、原生态FP8/FP4、专用大模型算子,计算效率提升5倍,能效比提升3倍,支撑更多计算任务。

(2)近存计算:采用3D内存混合键合,缩短计算与存储之间的距离,降低延迟,内存带宽提升10倍,访存能效比提升10倍。

(3)NB-Mesh新型互连:在超节点内实现纵向算力扩展(scale up),采用多维Full Mesh互连、直接内存语义访问、数据传输all reduce,提升芯片间的通讯效率,增强大规模计算的协同能力。

(4)新型封装:异质多Die封装WLP/PLP、UCIe D2D Chiplet、晶圆级封装(多达8个AI Die)、panel级封装(多达16个AI Die),进一步提升散热效率,解决高算力芯片的热管理问题。

(5)NB-Link通用扩展性:采用PCIe通用接口界面、CPU/NPU互连带宽达到1TB/s,CPU/NPU直接内存访问,加速AI Agent响应速度。

这些技术进展,为其迈向更高参数规模的大模型推理奠定了坚实的技术基础。

三、抢占AI推理蓝海,云天励飞的四大技术底气

云天励飞在AI推理芯片的技术积淀,主要体现在架构设计、技术积累、软件适配和互联互通四个方面。

首先是架构路线的选择,陈宁相信,NPU才是高性价比AI芯片首选,该架构能提供更高的计算效率,尤其适合处理深度学习算法,可在大规模推理中实现更高的算力密度和更低的能耗。

陈宁告诉芯东西,云天励飞的核心技术团队是全球最早研发NPU(并行计算处理器)的团队之一,有着20多年的NPU研发经验。

在他看来,除了团队能力强很重要外,团队的基因和信念也对研发AI芯片至关重要。云天励飞率先在国产工艺上实现边缘AI推理芯片的量产,已形成市场化差异。

在多次技术迭代中,团队不断突破现有的技术瓶颈,优化芯片设计,使得云天励飞的AI推理芯片逐步达到了国内领先水平。

除了硬件性能外,软件是AI芯片能否大规模落地的关键壁垒。

云天励飞已完成与多个主流推理框架的适配,并与智源研究院、无问芯穹等合作伙伴共同开发异构推理基础设施,为大规模AI模型的实际应用提供了强有力的支持。

为了支撑更大规模的多卡互连,云天励飞基于通用PCIe接口研发NB-Link技术,更适配国情,能与大多数国产芯片互连互通。该技术具有较好的扩展性,能够支持大规模AI推理任务中数据传输的高效性。

结语:下一步,推进标准与生态建设

云天励飞的技术路径中,自主可控的国产工艺和创新的“算力积木”架构起到了关键作用。依托国产工艺的自主研发,云天励飞不仅提升了产品的国产化率,还突破了现有国产芯片在大算力推理中的制约,为大模型推理提供了更强大的支撑。

随着芯片技术的不断进步,国产工艺的不断完善,其在AI推理芯片领域的技术积累逐渐趋向成熟。

现阶段,应对AI推理芯片爆发机遇,国产AI芯片仍需克服生态挑战,云天励飞正积极进行AI推理芯片的标准和生态建设,已建议ITU牵头组织AI推理芯片、算力网络国际标准,拓宽AI芯片在更多应用场景落地的普适性及商用空间。