Trainium3:3nm AI芯片破解算力瓶颈

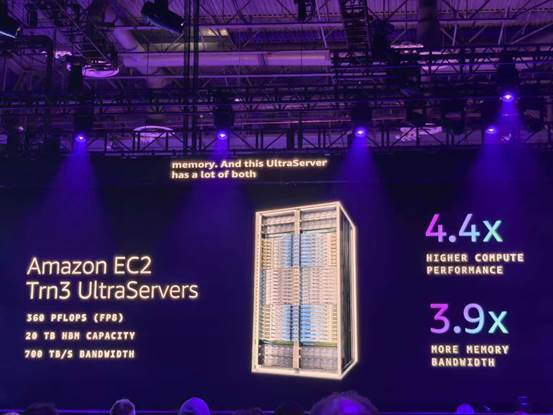

在re:Invent2025大会上,针对AI模型规模扩大带来的算力需求,亚马逊云科技推出首款3nm制程的Trainium3 AI芯片,并基于其打造Amazon EC2 Trainium3 UltraServers(Trn3 UltraServers),现已正式可用。

与上一代相比,Trn3 UltraServers计算性能提升4.4倍,能效提升4倍,内存带宽提升近4倍,单系统可集成144颗芯片,总算力达362 FP8 PFLOPs。

在实际场景中,Trainium3展现出强劲效能:运行OpenAI开源模型GPT-OSS时,单芯片吞吐量提升3倍,响应速度加快4倍,可将模型训练周期从数月缩短至数周。Anthropic、Ricoh等客户已通过Trainium系列将训练与推理成本降低50%,Amazon Bedrock也已在Trainium3上运行生产级工作负载。

Trainium3的算力突破需匹配低延迟网络才能释放最大价值,亚马逊云科技通过垂直集成的网络架构,为分布式AI计算打通了数据流动通道。

网络升级:构建无延迟的算力协同体系

分布式AI计算的通信瓶颈是行业共性难题,亚马逊云科技通过垂直集成的网络基础设施给出解决方案。Trn3 UltraServers搭载全新NeuronSwitch-v1与增强型Neuron Fabric网络,前者使单台服务器带宽提升2倍,后者将芯片间通信延迟降至不足10微秒。

未来布局:Trainium4开启跨架构协同

亚马逊云科技已经着手研发下一代Trainium4,其设计目标是在各项性能指标上实现显著提升,包括至少6倍的FP4处理性能、3倍的FP8性能以及4倍的内存带宽,以支撑下一代前沿模型的训练与推理需求。随着硬件与软件的持续优化,最终的整体性能提升将远高于这些芯片参数本身的提升幅度。

扩展性革新成为核心亮点:Trainium4将支持NVIDIA NVLink Fusion技术,实现与Graviton CPU、Elastic Fabric Adapter(EFA)在通用MGX机架内的无缝协作,构建兼容GPU与Trainium服务器的机架级AI基础设施,兼顾灵活性与高性能,为高要求AI工作负载提供优化平台。

从芯片到网络,从当前产品到未来布局,Peter DeSantis的分享勾勒出亚马逊云科技的基础设施革新逻辑:以全栈优化打破性能瓶颈,以定制化设计降低运营成本,最终让不同规模的企业都能以更低门槛获取AI时代的核心算力。